Automatische 3D-Erfassung von Körperzwangshaltungen am Arbeitsplatz

Titel des Projekts

PointCloud-4D – Entwicklung von Verfahren der automatischen 3D-Bewegungsanalyse auf Basis von 3D-Kameras, FuE-Teilprojekt: Strukturierte 3D-Bewegungsanalyse auf Basis von Tiefenbildkamera-Bildsequenzen

Förderung

Zentrales Innovationsprogramm Mittelstand des Bundesministerium für Wirtschaft und Energie (BMWi)

Motivation

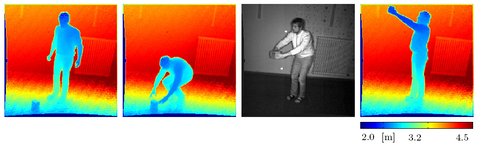

In der Arbeitswelt gibt es eine Vielzahl an Körperzwangshaltungen. Das Spektrum reicht vom Stehen mit Überkopfarbeit über Bücken bis hin zu einer Vielzahl an Kombinationen. Ungünstige Körperhaltungen und -bewegungen als ein Belastungsindikator berufsbedingter Muskel-Skeletterkrankungen sind in verschiedenen durch manuelle Arbeitsprozesse und physische Arbeit geprägten Branchen anzutreffen (z. B. Arbeitsplätze in Textil-, Bekleidungs- und Nahrungsmittelindustrie, Montage- und Verpackungsarbeitsplätze).

In Deutschland arbeiteten 2008 ca. 4,8 Mill. Beschäftigte in Körperzwangshaltungen. Muskel-Skeletterkrankungen verursachen mit einem Anteil von 24,7% die meisten Arbeitsunfähigkeitstage und bieten mit 8,5 Mrd. Euro Produktionsausfall das größte Präventionspotenzial in Unternehmen. Europäische Richtlinien und das deutsche Arbeitsschutzgesetz fordern die Durchführung ergonomischer Risikoanalysen am Arbeitsplatz sowie die Dokumentation der Ergebnisse als Grundlage zur Ableitung adäquater Gestaltungsmaßnahmen (Gefährdungsanalysen).

Die Analysen einer Arbeitssituation werden derzeit über Vor-Ort-Beobachtungen durchgeführt und anschließend manuell ausgewertet. Die etablierten Verfahren sind sehr zeit- und personalaufwendig und vorwiegend als "Papier- und Bleistiftmethode" konzipiert. Durch die beobachtende Einschätzung einzelner situativer Körperhaltungen, teils anhand von Piktogrammen, sind die Ergebnisse subjektiv geprägt und erfordern sehr viel Erfahrung und Routine.

Zielstellung

Gemeinsam mit unseren Kooperationspartnern entwickeln wir eine Technologie zur automatisierten 3D-Erfassung von Körperzwangshaltungen am Arbeitsplatz und zur anschließenden automatischen Ableitung von Risikoklassen als Maß für die Erstellung von Gefährdungsanalysen. Hierfür werden Winkeländerungen von Körpersegmenten (z. B. Verweildauer von Körperteilen in Gelenkwinkelbereichen, Gelenkwinkelausnutzung, Häufigkeit bestimmter eingenommener Gelenkwinkel) genutzt und zur Ergebnisinterpretation innerhalb ergonomischer Analysen herangezogen.

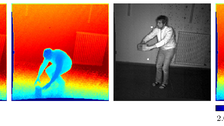

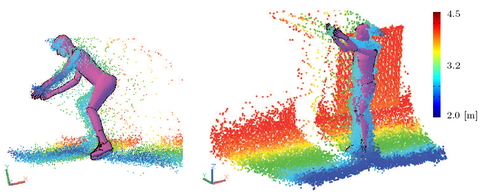

3D-Kameras nehmen zusätzlich zu einem Schwarzweißbild synchron ein Entfernungsbild auf, welches für jedes Bildpixel eine Entfernungsinformation enthält. Auf diese Weise werden räumlich aufgelöste 3D-Daten ohne die Notwendigkeit einer stereoskopischen Zuordnung gewonnen. 3D-Kameras sind somit als mono-sensorielle Systeme zur Echtzeit-Tiefenbildakquisition mit hoher zeitlicher Auflösung besonders für Anwendungen der menschlichen Bewegungsanalyse geeignet.

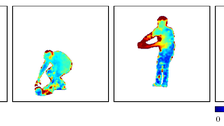

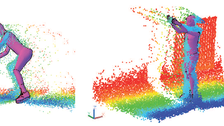

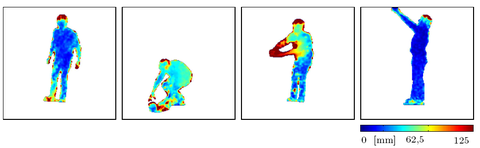

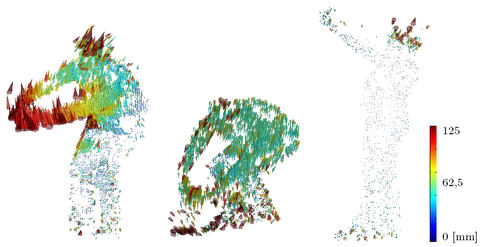

Der Einsatz einer 3D-Kamera bedingt die Entwicklung von Algorithmen zur strukturierten 3D-Bewegungsanalyse aus Bildsequenzen von 3D-Kameras sowie zur dynamische Anpassung (Fitting) parametrisierter Volumenobjekte aus dem CAD-Bereich in eine Sequenz von 3D-Punktwolken. Dazu werden durch einen integrierten Least-Squares-Tracking Ansatz 3D-Bewegungsvektorfelder bestimmt. Zusammen mit Tiefen- und Intensitätsbilddaten bilden diese Bewegungsvektorfelder die Basis zur detaillierten Segmentierung der Daten. Segmentierung und Bewegungsanalyse werden durch ein CAD-basiertes Objektmodell sowie durch Zwangsbedingungen der zu erwartenden Bewegung wissensbasiert unterstützt. Die segmentierten 3D-Punktwolken werden anschließend für jeden Zeitschritt in das parametrisierte Volumenobjekt eingepasst. Das Resultat der Verarbeitungskette ist eine genaue, objektteil-bezogene, zeitlich aufgelöste, parametrisierte, dreidimensionale Repräsentation von Bewegungsvorgängen in einer CAD-Darstellung.

Basierend auf den Ergebnissen der 3D-Bewegungsanalyse wird automatisch eine Gefährdungsanalyse abgeleitet, um den betrieblichen Praktiker bei der Beurteilung der Arbeitsbedingungen und der Ergebnisdokumentation effektiv und objektiv zu unterstützen.

Aufgaben

Die Professur für Photogrammetrie bearbeitet im Rahmen des Kooperationsprojektes die folgenden Aufgaben:

- Weiterentwicklung und Evaluation des integrierten Trackingansatzes 2.5D-LST

- Segmentierung von Intensitätsbild, Tiefenbild und Bewegungsvektorfeld

- Integration der Bewegungssegmente in durch die Fa. kubit GmbH zu entwickelnden top-down Fitting-Ansatz zur Ausnutzung des gesamten Informationshaushaltes

© IPF

© IPF

© IPF

© IPF

Relevante Publikationen

ProjektPartner

- Dr.-Ing. Oliver Bringmann, Dipl.-Inf. Armin Schmich, Dipl.-Inf. Tilo Pfliegner (kubit GmbH - Software für Vermessung und Datenerfassung)

- Prof. Dr.-Ing. Martin Schmauder, Dipl.-Ing. Daniel Gröllich (Professur für Arbeitswissenschaften)

Kontakt

- Prof. Dr. habil. Hans-Gerd Maas (Leitung)

- Dipl.-Ing. Patrick Westfeld (Bearbeitung)