Forschungsschwerpunkte

Inhaltsverzeichnis

- Softwaretechnologie und ihre Nutzung in cyber-physikalischen, mobilen und hardwarenahen Systemen

- Internet der Dienste, Cloud Computing und Sicherheit im Internet

- Datenintensives Rechnen und BigData, Wissensextraktion

- Mensch-Computer Interaktion und Visual Computing

- Formale Modellierung und Analyse artifizieller Systeme

- Modellierung, Maschinelles Lernen und Simulation natürlicher Systeme

Softwaretechnologie und ihre Nutzung in cyber-physikalischen, mobilen und hardwarenahen Systemen

Ansprechpartner: Prof. Dr. Uwe Aßmann

Software ist nicht nur zentraler Bestandteil von traditionellen Computersystemen, sondern Herzstück verteilter Anwendungen und zunehmend in Produkten und Geräten enthalten. In diesem Schwerpunkt stehen Forschungsaktivitäten zur Entwicklung von Architekturen, Technologien, komplexen Softwaresystemen und Anwendungen für verteilte und auch hardware-nahe Systeme im Vordergrund. Forschungsthemen sind u.a. Software als Service, Produktlinien-Engineering, komponentenbasiertes und modellgetriebenes Software-Engineering, Entwicklungsmethoden für kontextabhängige, adaptive Systeme, Internet der Dinge, Mobile Computing, mobile eingebettete Systeme und Optimierung der Energieeffizienz.

Internet der Dienste, Cloud Computing und Sicherheit im Internet

Ansprechpartner: Prof. Dr. Matthias Wählisch Dr.-Ing. Stefan Köpsell,

Ständig wachsende Mengen von Daten, Diensten, virtualisierten Computer-Ressourcen und Geschäftsprozessen werden ins Internet verlagert und sind allgegenwärtig von überall abrufbar. Vielfältige Forschungsaktivitäten dieses Schwerpunkts umfassen die Entwicklung von Methoden, Verfahren und Anwendungen in Bereichen wie Service und Cloud Computing, Mashups und Kompositionsansätze, Rich Internet Applications, Kontextadaption, mehrseitige Datensicherheit und Management heterogener Netze.

Datenintensives Rechnen und BigData, Wissensextraktion

Ansprechpartner: Prof. Dr. Wolfgang Nagel

Daten müssen heute weiter unterschieden werden in strukturierte Daten, teilstrukturierte Daten (z.B. Dokumente) und unstrukturierte Daten (z.B. Fotos, Videos) etwa im Web und in sozialen Netzwerken. Hinzu kommt eine stark zunehmende Verbreitung dynamischer Datenströme, z.B. aus Sensornetzwerken, die eine Verarbeitung und Analyse in Echtzeit erfordern. Die Nutzbarmachung dieser Daten ist eine der "Big Data" Herausforderungen, die auf der Basis der durch Internet Information Retrieval, Wissens- und Informationsextraktion, Data Clustering und Datenanalyse gegebenen Themen neue intelligente Verfahren zur Erfassung, Verarbeitung und Analyse der Daten benötigen, die dann auf IT-Infrastrukturen mit den nötigen Kapazitäten skalieren.

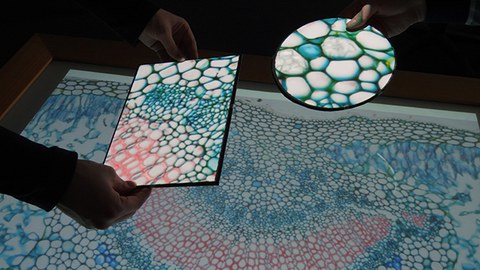

Mensch-Computer Interaktion und Visual Computing

Ansprechpartner: Prof. Dr. Raimund Dachselt, Prof. Dr. Stefan Gumhold

Vision ist ein intuitiver Umgang des Menschen mit Computertechnologie, die in alle Lebensbereiche integriert ist: mobile Geräte, neuartige Eingabe- und Displaytechnologien oder die digital erweiterte Alltagsobjekte umfasst und sich als "everywhere interaction" beschreiben lässt. Dafür sind grundlegende Forschungsfragen bezüglich Interaktionsdesign, Usability, Accessibility, User Experience und technischer Umsetzung zu beantworten. Forschungsschwerpunkte sind natürliche und multimodale Mensch-Computer-Interaktion mit interaktiven Oberflächen und in mobilen/ubiquitären Kontexten, Barrierefreiheit und Zugang für alle sowie damit verbundene didaktische Fragestellungen. Im Bereich Visualisierung, Computergrafik und Bildverarbeitung werden u.a. moderne Methoden zur Datenexploration und -analyse, zur wahrnehmungsorientierten Visualisierung komplexer wissenschaftlicher Daten, zur Informationsvisualisierung, zum 3D Scene Understanding, interaktiven Lernen oder für interaktive Bildsegmentierung grundlegend erforscht.

Formale Modellierung und Analyse artifizieller Systeme

Ansprechpartner: Prof. Dr. Franz Baader

Unter artifiziellen Systemen werden hier Systeme verstanden, die vom Menschen erzeugt sind. Diese Systeme sind entweder selbst Softwaresysteme oder sie werden durch Software ganz oder teilweise gesteuert. Die formale Modellierung derartiger Systeme ist in der Informatik ein wesentlicher Schritt beim Übergang von einer informellen Aufgabenbeschreibung zu einer formalen Durchdringung des zu lösenden Problems. Die Verwendung formaler Modelle mit wohldefinierter Semantik erleichtert den Austausch von Modellen und ermöglicht die automatisierte Analyse der Modelle. Diese Analyse umfasst sowohl den Nachweis von funktionalen Eigenschaften des Systems (z.B. Verifikation der Korrektheit) als auch die Untersuchung nichtfunktionaler Eigenschaften (z.B. Antwortzeit, Qualität der Ausgabe). Im Zentrum dieses Schwerpunktes steht die Entwicklung und Erforschung von Modellierungssprachen sowie die Entwicklung und Implementierung von Analysemethoden für formale Modelle unter Verwendung von Methoden der Algebra, der Künstlichen Intelligenz, der Theoretischen Informatik und der Wahrscheinlichkeitstheorie.

Modellierung, Maschinelles Lernen und Simulation natürlicher Systeme

Ansprechpartner: Prof. Dr. Björn Andres, Prof. Dr. Ivo F. Sbalzarini

Das Verstehen von natürlichen Systemen, z.B. aus der Biologie, realen Umwelt, oder Medizin, wird durch die computergestützte Analyse von komplexen Daten sowie die Modellierung und Simulation natürlicher Systeme vorangetrieben, wobei Steuerbarkeits- und Beobachtbarkeitsgrenzen überwunden werden können. Im Zentrum stehen die Bildverarbeitung und das Bildverstehen (Computer Vision) und die Computersimulation kontinuierlicher und diskreter Systemmodelle (Computational Science). Dabei spielt die numerische Optimierung, diskret und kontinuierlich, sowie das maschinelle Lernen dieser komplexen, oft strukturierten, Modelle (Machine Learning and Optimization) eine zentrale Rolle. Im interdisziplinären Zusammenspiel werden neue Theorien und Methoden entwickelt und in die Praxis umgesetzt. Die Anwendungen reichen von der Systembiologie (Center of Systems Biology Dresden) über Mensch-Maschine-Interaktion und Robotik bis hin zu den Ingenieurwissenschaften (Center for Advancing Electronics Dresden). Effiziente Algorithmen und der Einsatz paralleler Hochleistungsrechner erlauben es, große Datenmengen und Modellkomplexitäten nutzbar zu machen.