I/O-Analyse von Big-Data-Frameworks

Ziel: Grafische Analyse von proprietären Performance-Logs des Hadoop-Frameworks

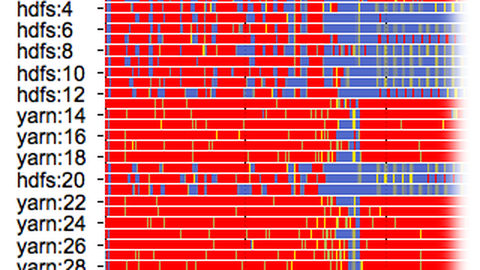

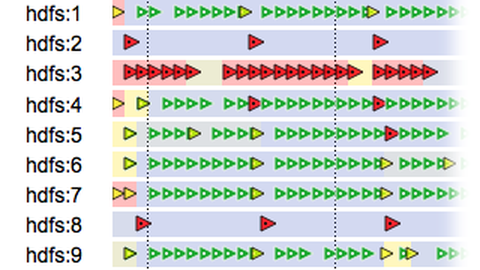

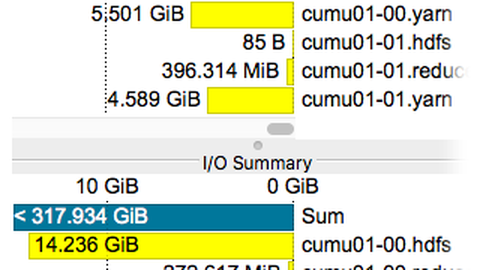

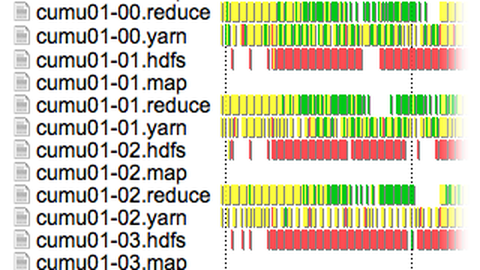

- Instrumentiertes Hadoop-Framework generiert HDFS Performance-Logs

- Logs werden mittels Python in das OTF2-Dateiformat konvertiert

- Die Software Vampir stellt zeitliche Entwicklung von Metriken (z.B. Auslastung oder gesendete/empfangene Daten) grafisch dar

Programmier-Frameworks im Big-Data-Kontext wie z.B. Hadoop, Flink oder Spark bringen mitunter ihre eigene virtuelle, verteilte Dateisystem-Infrastruktur. Im Kontext von Big-Data-Anwendungen wird diese Infrastruktur als gegeben und performant angenommen. Dabei ist i.d.R. wenig darüber bekannt, wie gut die darunter liegende I/O-Infrastruktur tatsächlich genutzt und ausgelastet wird. Vorhandene Werkzeuge zur I/O-Leistungsbewertung wie z.B. Darshan zeigen hier bestenfalls die Systemsicht. Eine Abbildung der Leistungsdaten auf Prozesse des Frameworks geschieht nicht. Am Zuse-Institut Berlin (ZIB) untersucht Herr Robert Schmidtke in seiner Forschungsarbeit das I/O-Verhalten von Big-Data-Analyse-Frameworks. Die Fallstudie zeigt, wie umfangreiche proprietäre I/O-Performance-Messdaten mit geringem Aufwand in das standardisierte Dateiformat OTF2 gebracht werden können, um sie mit dem Analyse-Werkzeug Vampir grafisch auszuwerten. Weiterlesen (englisch)

Kontakt

- Vampir Performance-Visualisierung, Koordination

Dr. Holger Brunst, ZIH - OTF2-Dateiformat Python-API und Datenkonvertierung

Sebastian Oeste, ZIH - HDFS Instrumentierung, Messung und Datenkonvertierung

Robert Schmidtke, ZIB